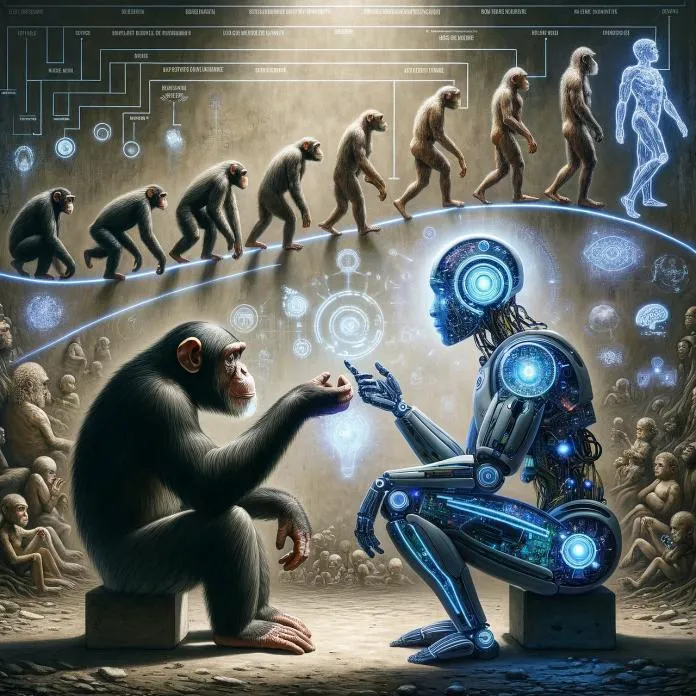

一位英国科学家在一篇富有启发性的新论文中提出,所谓的“人工智能”(AI)是否是我们从未在宇宙中发现其他智慧生物的原因之一?这一想法在费米悖论基础上形成:在一个无限的宇宙中,怎么可能没有其他文明向我们发送无线电信号呢?难道说,一旦文明发展出人工智能,它们中的大多数就会很快被遗忘?这种大规模事件被称为“大滤波器”,而人工智能是人们对其最热门的猜测对象之一。科技文明不可避免地发展人工智能,会不会造成我们从宇宙中听到的不可能发生的大寂静?

迈克尔-加勒特(Michael Garrett)是曼彻斯特大学的射电天文学家,也是朱德雷尔银行天体物理中心(Jodrell Bank Centre for Astrophysics)的主任,广泛参与地外智能搜寻(SETI)的工作。从根本上说,虽然他的研究兴趣不拘一格,但他是电视剧或电影中那些通过聆听宇宙来寻找其他文明迹象的人的现实版。在这篇经过同行评审并发表在《国际宇航科学院》杂志上的论文中,他将人工超级智能理论与射电天文学的具体观测结果进行了比较。

加勒特在论文中解释说,科学家们越是听不到任何其他智慧生命的迹象,就越是感到不安。他写道:“当把这种’大沉默’与其他天文学发现并列在一起时,就会产生一种悖论,因为其他天文学发现暗示宇宙对智慧生命的出现是很友好的。‘大过滤器’的概念经常被使用–这是一个普遍存在的障碍和不可逾越的挑战,阻碍了智慧生命的广泛出现”。

潜在的“大过滤器”数不胜数,从气候灭绝到有害的全球大流行病。任何事件都可能阻止全球文明走向多行星化。对于更多从意识形态上追随并相信大过滤器理论的人来说,人类在火星或月球上定居是降低风险的一种方式。这种想法认为,我们在地球上待得越久,大过滤器事件就越有可能消灭我们。

如今,人工智能的能力还无法接近人类智能。但是,加勒特写道,它正在做人们以前不相信计算机能做的工作。如果这一轨迹导致了所谓的通用人工智能(GAI)–这一关键区别意味着一种算法能够以真正人类的方式进行推理和综合想法,并结合令人难以置信的计算能力–我们就真的有麻烦了。在这篇论文中,加勒特通过一连串的假设,得出了一个可能的结论。一个文明需要多长时间才能被其自身不受监管的通用人工智能所毁灭?

在加勒特的设想中,只需要100-200年。他解释说,与太空旅行和定居这种杂乱无章的多领域工作相比,人工智能的编码和开发是一项涉及数据和处理能力并由数据和处理能力加速的单一项目。今天,我们看到了这种分裂,研究人员大量涌入计算领域,而生命科学领域却人才匮乏。推特上每天都有大言不惭的亿万富翁谈论定居火星有多么伟大和重要,但我们仍然不知道人类如何才能在旅途中生存下来而不被宇宙辐射摧毁。

关于这项研究,有一些重要的注意事项,或者说需要牢记的事情。加勒特通过一系列具体的假设情景,使用了大量的假设条件。他假设银河系中存在生命,人工智能和通用人工智能是这些文明的“自然发展”。他使用了已经假设过的德雷克方程,这是一种量化其他行星文明可能数量的方法,其中有几个变量我们还没有具体的概念。

不过,混合假设论证得出了一个强有力的结论:需要对人工智能进行严格和持续的监管。加勒特指出,地球上的国家已经在进行一场生产力竞赛,如果他们为了进行更多监管而犹豫不决,就会害怕错失良机。一些误入歧途的未来学家还有一个奇怪的想法,他们认为只要更快地开发出道德上良好的人工智能,就可以颠覆全球人工智能,从而对其进行更多的控制–这种说法毫无意义。

在加勒特的模型中,这些文明的人工智能时代只有几百年就会从地图上消失。在遥远的距离和漫长的宇宙时间中,这样微小的时间范围几乎毫无意义。他说,这与SETI目前0%的成功率相吻合。

加勒特解释说:“如果没有切实可行的监管措施,我们完全有理由相信,人工智能不仅会对我们的技术文明,而且会对所有技术文明的未来进程构成重大威胁”。(都市网Rick编译,图片来源pixabay)

(ref:https://www.popularmechanics.com/science/a60510513/ai-could-kill-us-in-200-years/)